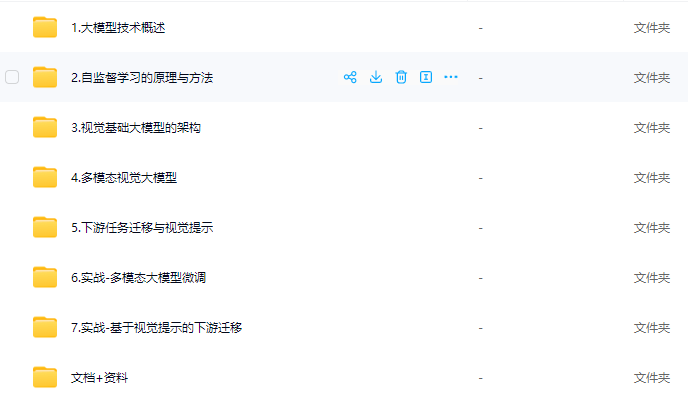

资源目录:

│ PPT.zip

│

├─1.大模型技术概述

│ 1. 视觉大模型技术概述.mp4

│ 1. 视觉大模型技术概述_ev.mp4

│

├─2.自监督学习的原理与方法

│ 2.1自监督学习与前置任务.mp4

│ 2.1自监督学习与前置任务_ev.mp4

│ 2.2对比学习与SimCLR.mp4

│ 2.2对比学习与SimCLR_ev.mp4

│ 2.3Moco模型.mp4

│ 2.3Moco模型_ev.mp4

│ 2.4MoCo代码详解.mp4

│ 2.4MoCo代码详解_ev.mp4

│ 2.5掩码重建与BEiT.mp4

│ 2.5掩码重建与BEiT_ev.mp4

│

├─3.视觉基础大模型的架构

│ 3.1 ViT与其变种.mp4

│ 3.1 ViT与其变种_ev.mp4

│ 3.2 MoCo v3自监督骨干网络.mp4

│ 3.2 MoCo v3自监督骨干网络_ev.mp4

│ 3.3 DINO模型.mp4

│ 3.3 DINO模型_ev.mp4

│ 3.4 DINO代码详解.mp4

│ 3.4 DINO代码详解_ev.mp4

│ 3.5 MAE模型.mp4

│ 3.5 MAE模型_ev.mp4

│ 3.6 MAE代码详解.mp4

│ 3.6 MAE代码详解_ev.mp4

│ 3.7 SAM模型.mp4

│ 3.7 SAM模型_ev.mp4

│

├─4.多模态视觉大模型

│ 4.1 多模态学习的概念.mp4

│ 4.1 多模态学习的概念_ev.mp4

│ 4.2 多模态网络的架构.mp4

│ 4.2 多模态网络的架构_ev.mp4

│ 4.3 CLIP模型.mp4

│ 4.3 CLIP模型_ev.mp4

│ 4.4 CLIP代码详解.mp4

│ 4.4 CLIP代码详解_ev.mp4

│ 4.5 GLIP模型.mp4

│ 4.5 GLIP模型_ev.mp4

│ 4.6 Flamingo模型.mp4

│ 4.6 Flamingo模型_ev.mp4

│ 4.7 LLaVA模型.mp4

│ 4.7 LLaVA模型_ev.mp4

│

├─5.下游任务迁移与视觉提示

│ 5.1 线性探测与微调.mp4

│ 5.1 线性探测与微调_ev.mp4

│ 5.2 线性探测与微调代码详解.mp4

│ 5.2 线性探测与微调代码详解_ev.mp4

│ 5.3 Adapter方法.mp4

│ 5.3 Adapter方法_ev.mp4

│ 5.4 Adapter代码详解.mp4

│ 5.4 Adapter代码详解_ev.mp4

│ 5.5 视觉prompt方法.mp4

│ 5.5 视觉prompt方法_ev.mp4

│ 5.6 视觉Prompt代码详解.mp4

│ 5.6 视觉Prompt代码详解_ev.mp4

│ 5.7 小结.mp4

│ 5.7 小结_ev.mp4

│

├─6.实战-多模态大模型微调

│ 6.1 PandaGPT框架介绍.mp4

│ 6.1 PandaGPT框架介绍_ev.mp4

│ 6.2 环境与模型配置.mp4

│ 6.2 环境与模型配置_ev.mp4

│ 6.3 项目代码通览.mp4

│ 6.3 项目代码通览_ev.mp4

│ 6.4 数据集加载.mp4

│ 6.4 数据集加载_ev.mp4

│ 6.5 模型定义.mp4

│ 6.5 模型定义_ev.mp4

│ 6.6 模型实现.mp4

│ 6.6 模型实现_ev.mp4

│ 6.7 Demo运行.mp4

│ 6.7 Demo运行_ev.mp4

│ code .zip

│ Vicuna模型加载指南.txt

│ 端口映射方法.txt

│

├─7.实战-基于视觉提示的下游迁移

│ 7.1 VPT框架通览.mp4

│ 7.1 VPT框架通览_ev.mp4

│ 7.2 数据集加载.mp4

│ 7.2 数据集加载_ev.mp4

│ 7.3 模型定义.mp4

│ 7.3 模型定义_ev.mp4

│ 7.4 模型实现1.mp4

│ 7.4 模型实现1_ev.mp4

│ 7.5 模型实现2.mp4

│ 7.5 模型实现2_ev.mp4

│ 7.6 病理图像下游迁移.mp4

│ 7.6 病理图像下游迁移_ev.mp4

│ BCI数据集下载.txt

│ code .zip

│

├─code

│ adapter.py

│ CLIP.py

│ DINO.py

│ linear-probing.py

│ MAE.py

│ moco.py

│ prompt-tuning.py

│ 全部代码压缩包.zip

│

├─PPT

│ 0.视觉大模型课程前置介绍.pptx

│ 1.大模型技术概述.pptx

│ 2.自监督学习的原理与方法.pptx

│ 3.视觉基础大模型的架构.pptx

│ 4.多模态视觉大模型.pptx

│ 5.下游任务迁移与视觉提示.pptx

│

└─论文

Gemini-A Family of Highly Capable Multimodal Models.pdf

ImageBind-One Embedding Space To Bind Them All.pdf

InternVL-Scaling up Vision Foundation Models and Aligning for Generic Visual-Linguistic Ta